mikemacmarketing, CC BY 2.0, via Wikimedia Commons

Antoine Boutet, INSA Lyon – Université de Lyon; Juliette Sénéchal, Université de Lille; Margo Bernelin, Université de Nantes et William Letrone, Université de Nantes

Depuis que les intelligences artificielles (IA) génératives, telles que ChatGPT pour le texte ou Stable Diffusion pour les images, sont entrées dans nos vies, elles ne laissent personne indifférent et suscitent fascination et crainte. Une machine peut en effet accomplir certaines tâches mieux qu’un humain, mais aussi commettre des erreurs. Entre les mains d’acteurs malintentionnés, une IA peut aussi servir à réaliser des deepfakes (contenus trompeurs) ou à influencer un résultat électoral.

Si laisser une machine résumer un texte semble peu risqué, la prise de décision automatisée par IA dans des contextes plus ou moins sensibles nécessite d’évaluer les risques et de les encadrer. Alors que le secteur de l’IA connaît une expansion fulgurante, la question de la réglementation de l’IA devient un sujet de préoccupation majeur pour les États. C’est donc dans ce contexte de course à l’encadrement que l’Union européenne (UE) entend promouvoir sa vision de la réglementation sur l’IA avec l’AI Act.

Pourquoi l’IA Act ?

Si l’UE manque encore de fleurons qui pourraient lui permettre de concurrencer les États-Unis et la Chine, il est un terrain où elle peut véritablement s’affirmer : celui de la régulation. En effet, au travers de l’AI Act, l’UE se met ainsi en capacité d’imposer ses règles aux autres acteurs en conditionnant l’accès au marché européen au respect de ses valeurs. C’est une étape décisive vers son objectif d’incarner un modèle de réglementation.

L’approche européenne s’articule autour du concept d’« IA digne de confiance » (ou trustworthy AI) et vise à faire de l’UE la pionnière des IA « légales », « éthiques » et « robustes ». Selon Carme Artigas, secrétaire d’État espagnole à la numérisation et à l’intelligence artificielle, il s’agit de « stimuler l’innovation et l’adoption de l’intelligence artificielle dans toute l’Europe tout en respectant pleinement les droits fondamentaux de nos citoyens. » Le défi est de taille, tant les enjeux politiques, économiques, et sociaux sont considérables. Le 13 mars dernier, les ambitions de l’UE se sont concrétisées avec l’adoption par le Parlement européen de l’AI Act au terme d’une longue procédure.

L’AI Act dans sa version préfinale prévoit des obligations variables en fonction du système ou du modèle d’IA et de son impact. L’étendue des obligations s’imposant aux fournisseurs et utilisateurs est proportionnelle aux risques d’atteinte aux droits fondamentaux posés par ces derniers. Ce faisant, il distingue entre les dispositifs d’IA posant des risques inacceptables pour les Européens, ceux posant des risques systémiques, ceux à haut risque, et enfin les dispositifs à risques faibles ou limités.

Une réglementation qui distingue différents niveaux de risque

Le règlement interdit d’abord les pratiques posant des risques inacceptables. Il s’agit des systèmes les plus intrusifs dont les usages peuvent avoir des conséquences néfastes démesurées sur les droits des usagers, comme l’utilisation de systèmes d’IA à des fins de manipulation pour influencer le comportement des individus (scandale Cambridge Analytica, analyse des données personnelles d’électeurs afin d’influencer leurs intentions de vote), les systèmes d’IA permettant de mettre en place un crédit social, et, sauf exception, les dispositifs d’identification à distance des personnes sur la base de caractéristiques personnelles comme la reconnaissance faciale algorithmique.

Ajoutés tardivement dans le règlement, les modèles de fondation (ou general-purpose AI models), de grands modèles d’intelligence artificielle exploitant de larges quantités de données et pouvant être adaptés pour effectuer plusieurs types de tâches, font l’objet d’un régime distinct. En fonction de leurs capacités, ils pourront être considérés comme posant un « risque systémique ». Cette catégorie concerne notamment ChatGPT dans sa version actuelle. Les fournisseurs de modèles posant un risque systémique seront soumis à des obligations renforcées par rapport aux autres modèles de fondation (entre autres, obligation de notification d’incidents de cybersécurité auprès de la Commission).

La catégorie des systèmes d’IA à haut risque s’applique aux systèmes susceptibles d’engendrer des conséquences néfastes importantes sur la santé, la sécurité et les droits fondamentaux des individus. L’utilisation de systèmes d’IA dans les procédures de recrutement, la détermination de l’obtention de droits sociaux ou de l’octroi de l’asile… relèvent de cette catégorie. Cette classification se traduit par des obligations variées allant de l’établissement d’un système de gestion des risques robuste, au maintien d’une documentation technique exhaustive, en passant par le respect des exigences en matière de gouvernance des données, de supervision humaine et de cybersécurité.

Les dispositifs à risques faibles ou limités restent quant à eux soumis à l’obligation de transparence commune à tout système destiné à interagir directement avec les personnes. Cette catégorie concerne surtout les systèmes d’IA ayant une influence minime sur la prise de décision et inclut les systèmes cantonnés à des tâches très spécifiques comme la classification de dossier ou la correction orthographique.

Un texte bienvenu mais imparfait

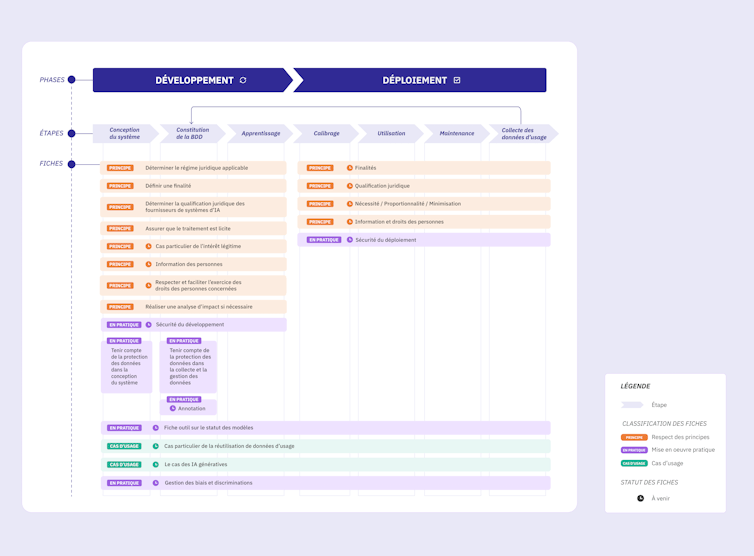

La gouvernance de ce cadre sera assurée par un nombre conséquent d’institutions européennes et nationales, à l’image du Comité européen de l’intelligence artificielle et du Bureau européen de l’IA, questionnant la lisibilité du dispositif. En France, la Commission nationale de l’informatique et des libertés (CNIL) s’est déjà positionnée en renforçant son expertise sur l’IA, laquelle se traduit notamment par la publication de fiches de recommandation pour le développement et le déploiement des systèmes d’IA.

CNIL, CC BY-NC

Le texte était largement attendu, notamment par les acteurs de l’industrie créative, mais aussi par des juristes et organismes indépendants. Pourtant, l’adoption du texte n’a pas été simple, la France, l’Allemagne et l’Italie se montrant particulièrement réticentes à l’égard des dispositions portant sur les modèles de fondation, y voyant un frein potentiel au développement de l’IA en Europe. Dans ce domaine, le règlement ne semble pas satisfaire toutes les parties.

Il est notamment reproché à l’AI Act de proposer une définition inadéquate des modèles de fondation « à risque systémique », une insuffisance à laquelle le Bureau européen de l’IA (chargé entre autres d’éclairer la mise en œuvre de l’AI Act) devra pallier rapidement. Par ailleurs, plusieurs compromis ont été critiqués comme pouvant donner lieu à des abus, comme la possibilité laissée aux États d’utiliser des dispositifs d’identification biométrique en temps réel pour des motifs de sécurité nationale.

Combiner l’AI Act et les textes déjà en vigueur

En outre, la mise en conformité au règlement, en particulier pour les systèmes à haut risque, est subordonnée au respect de standards techniques relatifs à la qualité des systèmes, à leur sécurité ou encore à la gouvernance des données qui reste encore à déterminer. Dans cette perspective, les efforts s’intensifient pour proposer des standards techniques pertinents.

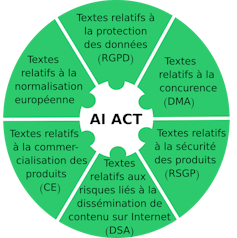

Antoine Boutet, Juliette Sénéchal, Margo Bernelin et William Letrone, Fourni par l’auteur

Enfin, l’AI Act n’épuise pas toutes les questions soulevées par l’IA ni les besoins d’encadrement. Il faudra donc combiner sa lecture avec d’autres textes comme le Règlement général sur la protection des données (RGPD) dans le cas d’IA impliquant un traitement de données personnelles, ou le Règlement sur les services numériques (ou Digital Services Act – DSA) et le Règlement sur les marchés numériques (ou Digital Market Act – DMA) dans le cas d’IA intégrées à des plates-formes de services.

Quoiqu’il en soit, en Europe comme ailleurs, il n’est plus question de laisser les grandes sociétés de l’IA s’autoréguler. Reste à espérer que la phase de mise en œuvre parvienne à réduire les zones d’ombres qui subsistent à ce stade.

Le projet IPoP est soutenu par l’Agence nationale de la recherche (ANR), qui finance en France la recherche sur projets. Elle a pour mission de soutenir et de promouvoir le développement de recherches fondamentales et finalisées dans toutes les disciplines, et de renforcer le dialogue entre science et société. Pour en savoir plus, consultez le site de l’ANR.![]()

Antoine Boutet, Maitre de conférence, Privacy, IA, au laboratoire CITI, Inria, INSA Lyon – Université de Lyon; Juliette Sénéchal, Professeur de droit privé, Université de Lille; Margo Bernelin, Chargée de recherche CNRS, Université de Nantes et William Letrone, Chercheur post-doctorant en droit de la cybersécurité et droit de la protection des données personnelles, Université de Nantes

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.

![]()