Julien Pillot, INSEEC Grande École

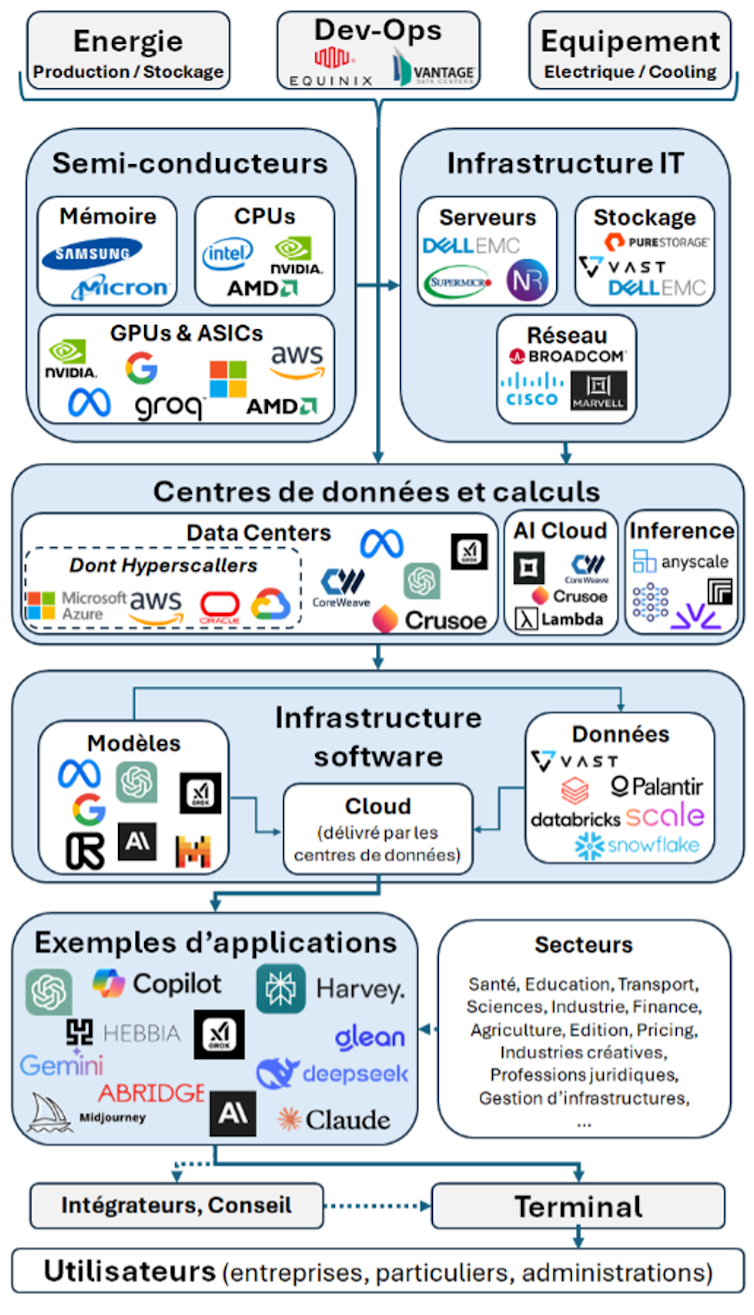

Derrière la relative facilité d’une requête sur ChatGPT se trouve un écosystème complexe d’entreprises. Passage en revue des principaux intervenants et des défis qui se posent à eux. Dans cet environnement, les entreprises européennes sont encore trop absentes. Pourront-elles rattraper leur retard ?

Derrière l’intelligence artificielle (IA) se trouve un écosystème complexe et dynamique. Ce dernier comporte bien plus que des algorithmes et les stars de l’IA que sont devenus en quelques mois les OpenAI, Mistral et autres DeepSeek.

Cet écosystème diversifié attire les investissements par milliards) et alimente bien des fantasmes et spéculations. Alors que s’ouvre le sommet de l’IA en France), quels sont les principaux rouages de l’IA ? Les principaux maillons de sa chaîne de valeur ?

Les IA génératives au centre de l’attention

Les applications à destination des utilisateurs professionnels comme particuliers – les IA génératives – constituent la partie la plus visible de l’ensemble. Elles aident à produire en un temps record des textes, des images et même des sons et des vidéos, particulièrement convaincants.

Si les IA génératives les plus célèbres sont généralistes, à l’image de ChatGPT, Grok ou Gemini, d’autres sont spécialisées : Harvey est destinée aux professionnels du droit, Arbridge à ceux de la santé… Ces applications offrent l’avantage de se focaliser sur un domaine dans lequel elles entendent être excellentes, et sont très souvent moins énergivores que leurs analogues généralistes.

Cette distinction entre IA générales et IA spécialisées est d’autant plus centrale que la plupart des secteurs d’activité connus sont en attente (ou utilisent déjà) de solutions ad hoc, qui seront très probablement apportées par des IA spécialisées, s’appuyant sur d’autres modèles que ceux à l’origine des IA génératives. Par exemple Tesla et Google dans la conduite autonome, Alphago dans la maîtrise du jeu de go, ou des entreprises telles que iCad, PaigeAI ou Imagene

AI dans la détection de cancers, n’utilisent pas les mêmes approches et les mêmes types de modèles d’entraînement que les IA génératives. C’est aussi dans l’application hyperspécialisée des solutions IA que résident les gains de productivité les plus conséquents.

Une vision de l’écosystème de l’IA

Les entreprises choisies pour illustrer l’infographie l’ont été de façon arbitraire, sans présumer de leurs performances passées ou futures sur leurs marchés respectifs

Machines à vecteurs, arbres ou neurones ?

Si les terminaux sont essentiels à la fourniture du service aux utilisateurs finaux, pour fonctionner, ces applications doivent avant tout s’appuyer sur une « infrastructure software ». Infrastructure dans laquelle nous allons d’abord trouver des entreprises spécialisées dans la création de modèles. Construit autour d’algorithmes qui apprennent à partir de données, un modèle d’IA doit être compris comme une représentation computationnelle de la capacité à apprendre et à prendre des décisions, ou bien à effectuer des tâches basées sur cette capacité. Leurs structures sont multiples, les plus répandues étant les réseaux neuronaux, les arbres de décision, les machines à vecteurs de support et autres méthodes de machine-learning. Des entreprises comme Meta, xAI, Open AI ou Mistral opèrent dans ce domaine.

[Déjà plus de 120 000 abonnements aux newsletters The Conversation. Et vous ? Abonnez-vous aujourd’hui pour mieux comprendre les grands enjeux du monde.]

Dans cette architecture software, on trouve également des entreprises telles que Palantir ou Databricks qui sont spécialisées dans la délivrance de données nécessaires à l’entraînement des modèles. Lorsqu’elles sont sollicitées, ces entreprises portent une responsabilité importante dans la qualité des résultats produits par les modèles puisqu’elles en fournissent le carburant. Enfin, ces modèles sont appelés par l’utilisateur de façon distante via son terminal numérique, ce qui exige une infrastructure cloud.

L’importance du nuage

On l’oublie un peu trop souvent mais, bien loin d’être immatériels, les services numériques s’appuient sur des infrastructures lourdes dédiées essentiellement aux fonctions de calcul et au stockage, ainsi que des infrastructures de télécommunications (absentes de notre infographie par souci de simplification). Les centres de données sont ainsi le centre névralgique de l’écosystème IA. Or, si ce segment de marché est largement dominé par les « hyperscalers », ces géants globaux du cloud (Amazon avec AWS, Microsoft, Alphabet…) capables de gérer et de traiter d’énormes quantités de données à très grande échelle et avec des temps de latence très faibles, il ne faut par oublier la multitude de concurrents, souvent régionaux, et parfois mieux-disants sur les aspects environnementaux ou de confidentialité des données.

Ces centres de données sont donc des infrastructures qui peuvent fonctionner en symbiose avec des services d’AI cloud et d’inférence. Les premiers mettent à disposition, via Internet, les capacités de calcul et de stockage des centres de données à la demande de développeurs ou d’entreprises qui sont intéressées par lesdites capacités, mais sans avoir les moyens d’investir dans des infrastructures lourdes et onéreuses. Les seconds délivrent un service consistant à appliquer les mégamodèles (ceux ayant été entraînés sur d’immenses quantités de données que nous avons abordées dans la partie « infrastructure logicielle ») au monde réel pour accomplir, via l’analyse de données nouvelles et non vues auparavant (souvent liées à l’action de l’utilisateur), des tâches précises telles que la génération de contenu, la traduction, la reconnaissance d’image ou la classification. Si l’inférence est le plus souvent déployée dans le cloud, elle peut l’être au niveau des terminaux, notamment pour protéger la confidentialité des données.

Indispensables puces

Bien naturellement, ce tour d’horizon de l’amont de la chaîne de valeur de l’IA ne serait pas complet sans évoquer les différents fournisseurs essentiels à la création, l’exploitation, l’interconnexion et l’alimentation de ces centres de données. Ceux-ci sont de grosses infrastructures faisant appel à de l’ingénierie et des équipements spécifiques. Les Devs-Ops tels qu’Equinix ou Vantage ont une maîtrise d’œuvre qui leur permet d’intervenir dans la création de centres de données pour des tiers, mais aussi de fournir des centres de données « neutres » à l’échelle mondiale dans lesquels des entreprises pourront héberger leurs contenus ou effectuer des calculs.

Plus dans le détail, les centres de données reposent sur des équipements IT spécifiquement dédiés au stockage, à la connectivité, au refroidissement… mais aussi, et surtout, sur des semi-conducteurs fournissant la mémoire et la puissance de calcul indispensables à l’entraînement des modèles et à l’inférence. C’est ici que les GPUs et les ASICs prennent une place prépondérante, et une part substantielle de la valeur ajoutée.

Variation du cours en bourse de Nvidia

Ces puces – flexibles pour les premières et spécialisées (optimisées) pour les secondes – sont à même de gérer des calculs de haute performance grâce à leur architecture parallèle. Si une entreprise comme Nvidia a vu sa capitalisation multipliée par 20 en 5 ans pour atteindre, au moment où nous rédigeons ces lignes, les 3000 milliards de dollars, cela s’explique par son leadership technologique et industriel en la matière. Pensons que ses GPUs de génération H-100 sont présentés au prix de 25 000 dollars pièce, et qu’il n’est pas rare de les trouver à près de 50 000 sur le marché secondaire. Quand on sait qu’un projet tel que Stargate prévoit de mobiliser quelque 100 000 GPUs H-100…

Une Europe de l’IA est-elle possible ?

Ce survol de la chaîne de valeur de l’IA ne saurait être exhaustif, et occulte de nombreux acteurs plus confidentiels, force est de constater que l’Union européenne peine à faire émerger des champions de l’IA. Tout espoir n’est pas perdu pour autant. Les positions de marché ne sont pas encore figées, à plus forte raison que les défis à relever sont nombreux et peuvent permettre à de nouveaux acteurs d’intégrer victorieusement l’écosystème.

Pensons, tout d’abord, au défi de la sobriété. Les solutions IA s’appuient sur des infrastructures gourmandes en ressources, notamment en métaux, en énergie et en eau. L’émergence de DeepSeek montre que cela n’est pas une fatalité. Hypothèse faite que l’entreprise a été parfaitement transparente sur les ressources mobilisées, son existence montre qu’il y a de la place pour des solutions « good enough », basées sur l’open source, moins onéreuses et s’appuyant sur des architectures « Mixture of Experts » nettement moins énergivores que les architectures « Transformers » mobilisées par les solutions nord-américaines.

Il y a ensuite le défi de la souveraineté. Pourquoi continuer à systématiquement confier nos grands marchés publics aux géants de la Tech américains dont on sait qu’il sont susceptibles, en vertu du FISA (Foreign Intelligence Surveillance Act), de communiquer les données en leur possession aux autorités fédérales ? À titre d’exemple, la France a récemment fait le choix de confier la gestion des données de santé à Microsoft, et celle des données relatives à la maintenance de son parc nucléaire à Amazon. N’était-il pas envisageable de réserver ces marchés, extrêmement sensibles, à des acteurs français ou européens s’appuyant sur des infrastructures plus décentralisées et surtout plus soucieux des questions de confidentialité ? Réserver la commande publique aux acteurs européens, outre d’envoyer un message ferme aux velléités protectionnistes américaines, permettrait de compenser quelque peu le déficit de dynamisme de notre marché du « venture capital ».

Il y a enfin le défi économique et concurrentiel. À force d’intégration verticale, certaines entreprises telles que Microsoft, Amazon ou Google prennent d’ores et déjà des positions tout au long de cette chaîne de valeur de nature à préoccuper les autorités de concurrence. La puissance de leurs solutions techniques et de leur marketing, couplée à des modèles propriétaires de nature à même de rendre les utilisateurs captifs, pourraient à terme verrouiller l’accès au marché. Un argument supplémentaire pour que l’Europe joue pleinement la carte de l’open source.

Enfin, il faut bien garder à l’esprit qu’une grande par de la valeur sera captée par les entreprises de cet écosystème qui, en bout de chaîne, seront capables de délivrer des solutions spécialisées offrant les niveaux de gains de productivité attendus par le marché. À cette aune, alors que les solutions existantes peinent à produire des effets productifs à la hauteur des promesses formulées, les jeux sont encore bien ouverts.![]()

Julien Pillot, Enseignant-Chercheur en Economie, INSEEC Grande École

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.

![]()